在电商与时尚产业深陷“试穿难、退货率高、展示成本攀升”的行业困局之际,AI换衣技术不断迎来关键突破。

从早期依赖GAN生成纹理,到扩散模型提升图像真实感,2023年中山大学提出的GP-VTON通过协作局部流全局解析学习,推动AI换衣技术迈入通用化阶段。近两年,多模态大模型的应用进一步优化了上半身生成的效果,让AI换衣技术呈现爆发式发展,但个别服装和身体细节表现仍显不足。

东信营销科技集团基于前沿的CatVTON架构,创新融合CatVTON拼接式扩散模型与Flux fill inpainting修复模型形成双模型协同机制(CatVTON-FLUX),并引入In-Context LoRA技术优化提示工程,正式推出“虚拟试衣间”智能体。该解决方案能确保服装在复杂姿态下贴合度达90%以上,训练成本较传统方案降低10倍,显著提升了生成效率与真实感。同时,还支持上衣、裤装、裙装、鞋子等全品类换装,无需人工标注即可实现高保真、低门槛、全场景的虚拟换装体验,加速为商家与消费者构建“所见即所得”商业闭环。

体验地址:http://mlm.yingsaidata.com/square

真实性与保真度难以兼得

商业虚拟试衣需高度还原服装细节(如面料微纹理、动态反光、图案定位等),而现有模型受限于实时算力,在“高保真纹理渲染”与“姿态驱动的物理形变模拟”间存在资源竞争矛盾。

泛化能力与个性化体验相互矛盾

电商虚拟试衣模型需同步解决动态姿态下的服装形变精度与材质细节还原问题,但高度定制化设计受限于训练数据覆盖范围,对未见的体型变体或极端动作泛化能力不足。

数据依赖严重,额外的网络设计,训练成本高

传统虚拟试穿模型依赖复杂网络架构与高质量标注数据,另外,数据采集、数据清洗、数据标注需要较长的时间周期,训练模型也对显卡提出较高的要求,因此训练服装上身模型的时间成本与硬件成本均居高不下。

推理时间成本高,难以实现商业化

当前文生图、图生图大模型大都是基于扩散模型进行的,扩散模型需要逐步预测噪声、去除噪声才能实现生图功能,逐步预测去除噪声的过程需要多次迭代才能实现,因此需要较高的推理时间成本,商业化难度较高。

智能化·多模态驱动的智能换装体验

东信“虚拟试衣间”智能体基于多模态模型Janus-Pro,结合定制化Prompt设计,可自动理解模特姿态与穿着上下文,实现不同场景下的智能服装迁移,精准匹配多类换装需求。

↑ 东信「虚拟试衣间」智能体换装展示

精准化·高保真贴合与细节还原

针对复杂多变的试穿场景,东信“虚拟试衣间”智能体引入自研的自适应自主分割方法,通过集成Janus-pro大模型进行试穿场景感知与预测,提升人物与服装之间边界区域的感知精度,再融合ACE++模型作为辅助模型,利用ACE++的细节迁移能力,有效增强服装纹理、褶皱、光影的一致性与真实感,呈现更高颗粒度的视觉效果。

系统化·模块解耦,服务灵活可调

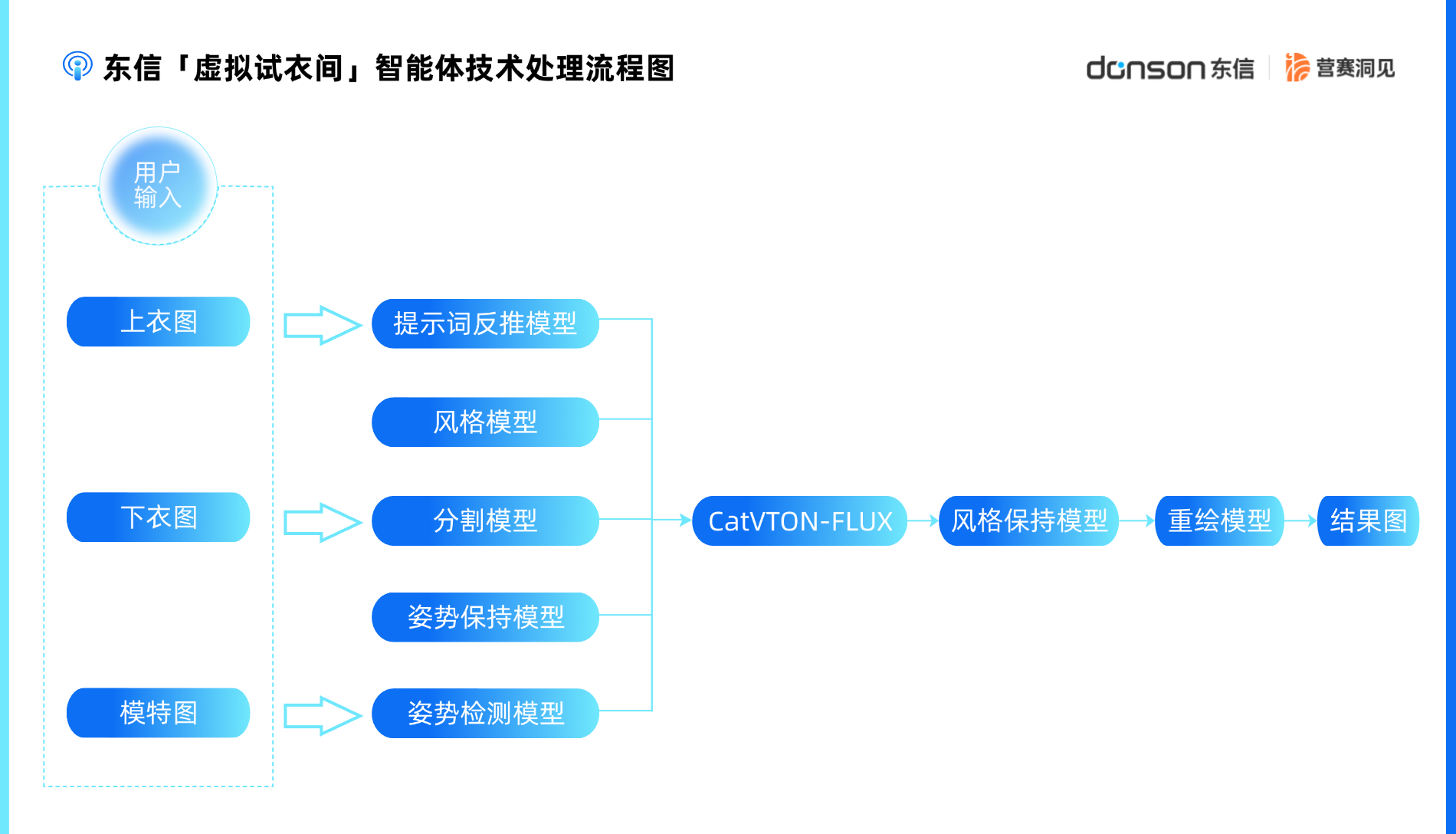

东信构建涵盖“多模态理解 - 图像分割 - 服装重绘”的三大核心模块,并围绕扩散模型进行深度协同。同时模块高度解耦,可按需单独部署为独立API接口,满足灵活接入与高可用服务需求。

↑ 东信「虚拟试衣间」智能体技术处理流程图

专业化·营销场景中的行业领先方案

依托东信时代20多年的营销行业深耕与2290 亿条营销数据积累,驱动自研AI换装引擎持续迭代,在商品展示、内容营销等应用中实现精准投放与高转化,为商家提供更具实效的AI解决方案。

当服装展示突破时空与成本限制,当消费者指尖轻滑即可驾驭万千风格——东信以超高的细节精度与场景化智能,重新定义AI换衣技术。

这不仅是工具层面的革新,更通过重构生产、营销销售与消费链路,推动行业向高效化、个性化与全球化演进。其价值已从单一的成本优化扩展至全产业链的数字化升级,成为“新质生产力”的典型代表。